Over-fitting을 감소시키는 좋은 방법은 규제를 하는 것.

자유도를 줄이면 데이터에 over-fitting되기 어려움.

ex) 다항 회귀 모델을 규제하는 간단한 방법은 차수를 감소시키는 것.

선형 회귀 모델에ㅐ서는 보통 모델의 weight를 제한함으로써 규제를 함.

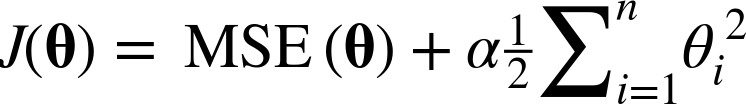

1. 릿지 규제(ridge regularization)

위 수식이 cost fuction에 추가됨.

이는 학습 알고리즘을 데이터에 맞추는 것뿐만 아니라 모델의 가중치가 가능한 한 작게 유지되도록 노력

당연히도, regularization term은 학습 중에만 loss function에 추가

α는 모델을 얼마나 많이 규제할지 조절하는 파라미터

α가 0이면 ridge regression은 linear regression과 동일

α가 매우 크면 모든 가중치가 거의 0에 가까워짐.

(i가 1부터 시작하는 이유는 편향 θ_0이 규제되지 않기 때문에)

만약 여기서 w를 feature weight vector(θ1 to θn)로 정의한다면

regularization term은 아래와 같이 작성할 수 있다.

위는 weight vector의 l2 norm

이 글의 내용은 많은 부분 아래 링크인 핸즈온 머신러닝 2판을 참고했으며

영리 목적이 아닌 개인적인 학습을 위해 정리한 내용을 바탕으로 작성했음을 밝힙니다.

내용 참고

https://book.naver.com/bookdb/book_detail.nhn?bid=16328592

핸즈온 머신러닝

머신러닝 전문가로 이끄는 최고의 실전 지침서 텐서플로 2.0을 반영한 풀컬러 개정판 『핸즈온 머신러닝』은 지능형 시스템을 구축하려면 반드시 알아야 할 머신러닝, 딥러닝 분야 핵심 개념과

book.naver.com

'딥러닝관련 > 기초 이론' 카테고리의 다른 글

| 소프트맥스 회귀(softmax regression) (0) | 2022.03.06 |

|---|---|

| 로지스틱 회귀(logistic regression) (0) | 2022.03.02 |

| 편향/분산 트레이드 오프 (Bias/variance trade-off) (0) | 2022.02.27 |

| 다항 회귀 (polynomial regression) (0) | 2022.02.21 |

| Mini-batch Gradient Descent(미니배치 경사 하강법) (0) | 2022.02.20 |