2022.02.20 - [딥러닝관련/기초 이론] - Stochastic gradient descent(확률적 경사 하강법)

Stochastic gradient descent(확률적 경사 하강법)

2022.02.20 - [딥러닝관련/기초 이론] - 경사 하강법(Gradient Descent) 경사 하강법(Gradient Descent) 2022.01.24 - [딥러닝관련/기초 이론] - 선형 회귀 (Linear Regression) 선형 회귀 (Linear Regression) 선..

better-tomorrow.tistory.com

위 글로부터 이어짐

Mini-batch gradient descent(미니배치 경사 하강법)

(사실 이 방법이 실제 환경에서 제일 많이 쓰인다.)

간단하게 표현하면 아래와 같다.

전체 training sets (batch gradient descent)

일부의 sample들 (Mini-batch Gradient Descent)

하나의 sample (stochastic gradient descent)

mini-batch gradient descent의 주요 장점은

행렬 연산에 최적화된 하드웨어, 특히 GPU를 사용해서 얻는 성능 향상

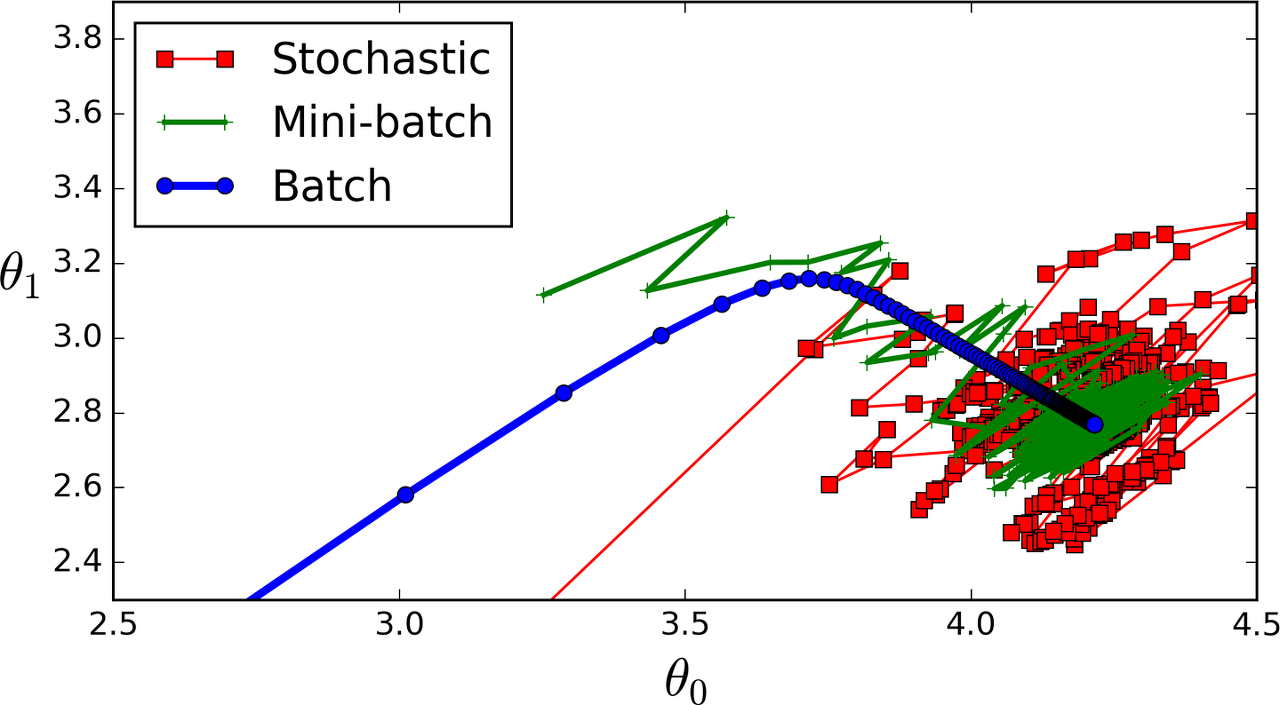

특히 mini-batch를 증가 시키면 이 알고리즘은 parameter 공간에서 SGD보다 덜 불규칙하게 움직인다.

(SGD보다 최솟값에 더 가까이 도달할 가능성이 높지만, 그만큼 local minimum에서도 빠져나오기 힘들 수 있다.)

위 그림은 세 가지 gradient descent 알고리즘이 training 과정 동안 parameter space에서 움직인 경로.

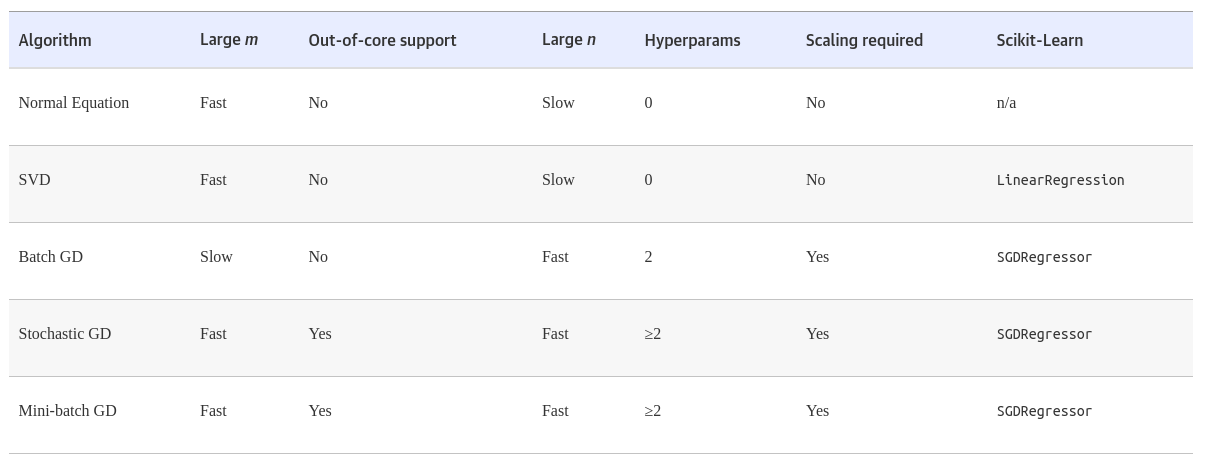

아래는 지금까지 언급한 알고리즘 비교표

이 글의 내용은 많은 부분 아래 링크인 핸즈온 머신러닝 2판을 참고했으며

영리 목적이 아닌 개인적인 학습을 위해 정리한 내용을 바탕으로 작성했음을 밝힙니다.

내용 참고

https://book.naver.com/bookdb/book_detail.nhn?bid=16328592

핸즈온 머신러닝

머신러닝 전문가로 이끄는 최고의 실전 지침서 텐서플로 2.0을 반영한 풀컬러 개정판 『핸즈온 머신러닝』은 지능형 시스템을 구축하려면 반드시 알아야 할 머신러닝, 딥러닝 분야 핵심 개념과

book.naver.com

'딥러닝관련 > 기초 이론' 카테고리의 다른 글

| 편향/분산 트레이드 오프 (Bias/variance trade-off) (0) | 2022.02.27 |

|---|---|

| 다항 회귀 (polynomial regression) (0) | 2022.02.21 |

| Stochastic gradient descent(확률적 경사 하강법) (0) | 2022.02.20 |

| 경사 하강법(Gradient Descent) (0) | 2022.02.20 |

| Swin Transformer (0) | 2021.11.25 |