ReLU

Relu의 수식은 아래와 같다.

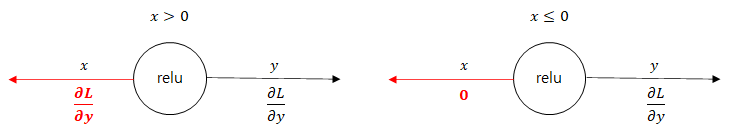

이를 x에 대한 y 미분을 거치면 아래와 같다.

Feed forward 단계에서 입력인 x가 0보다 크면 역전파는 상류의 값을 그대로 하류로 흘린다.

반대로, x가 0 이하이면 역전파 때는 하류로 신호를 보내지 않는다(0을 보낸다)

내용 참고

book.naver.com/bookdb/book_detail.nhn?bid=11492334

밑바닥부터 시작하는 딥러닝

직접 구현하고 움직여보며 익히는 가장 쉬운 딥러닝 입문서!『밑바닥부터 시작하는 딥러닝』은 라이브러리나 프레임워크에 의존하지 않고, 딥러닝의 핵심을 ‘밑바닥부터’ 직접 만들어보며

book.naver.com

'딥러닝관련 > 기초 이론' 카테고리의 다른 글

| 신경망 정리 (학습 관련 기술들 - optimizer) (0) | 2021.08.16 |

|---|---|

| 신경망 정리 10-2 (오차 역전파 활성화 함수 계층 구현, Sigmoid) (0) | 2021.07.19 |

| 특이값 분해 (singular decomposition) (0) | 2021.06.04 |

| 신경망 정리 9 (연쇄 법칙 chain rule) (0) | 2021.05.30 |

| 신경망 정리 8 (오차역전파법) (0) | 2021.05.29 |